最近开始秋招,复习一下以前学过的ML,记录一下常见的秋招问题

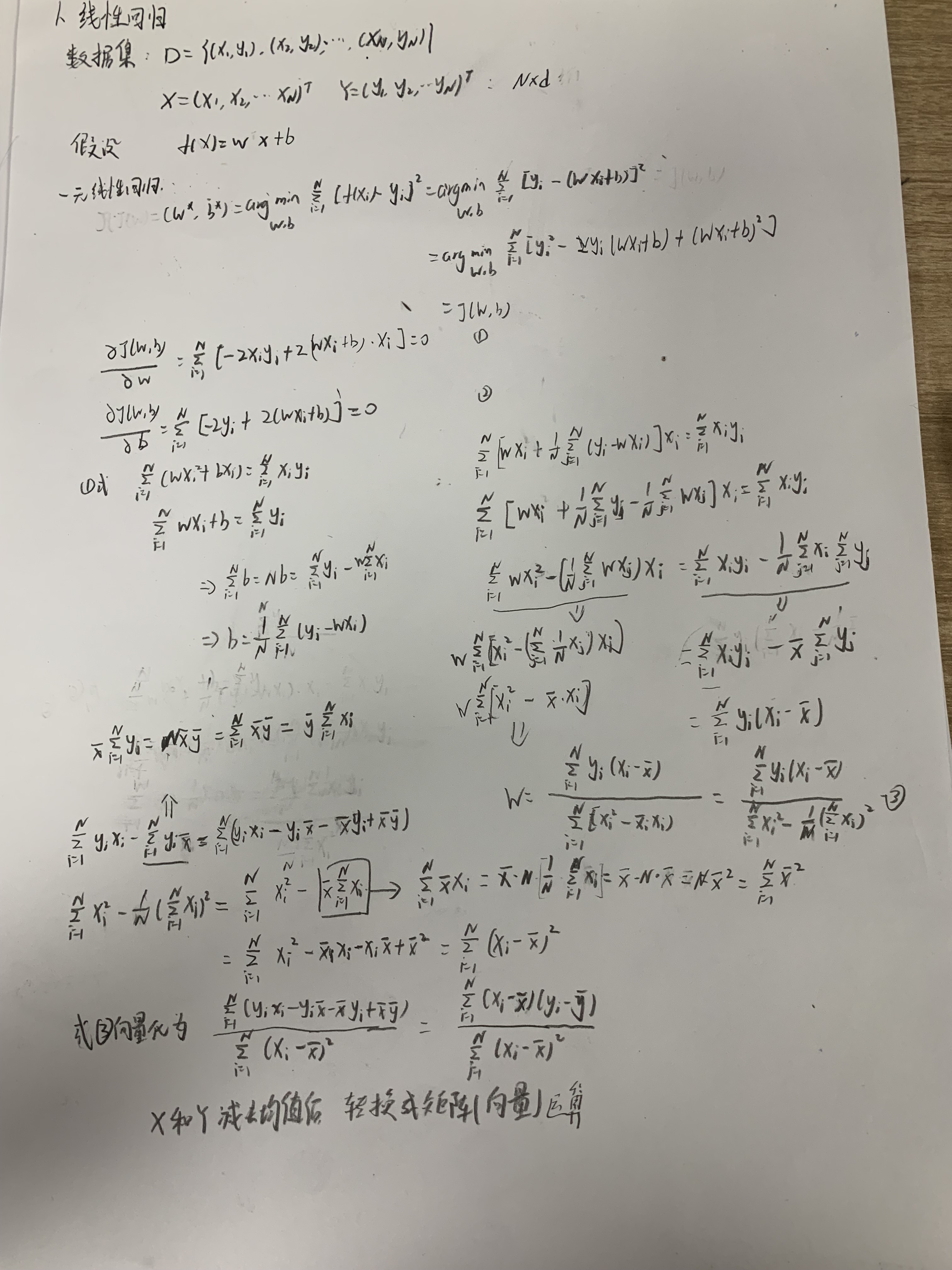

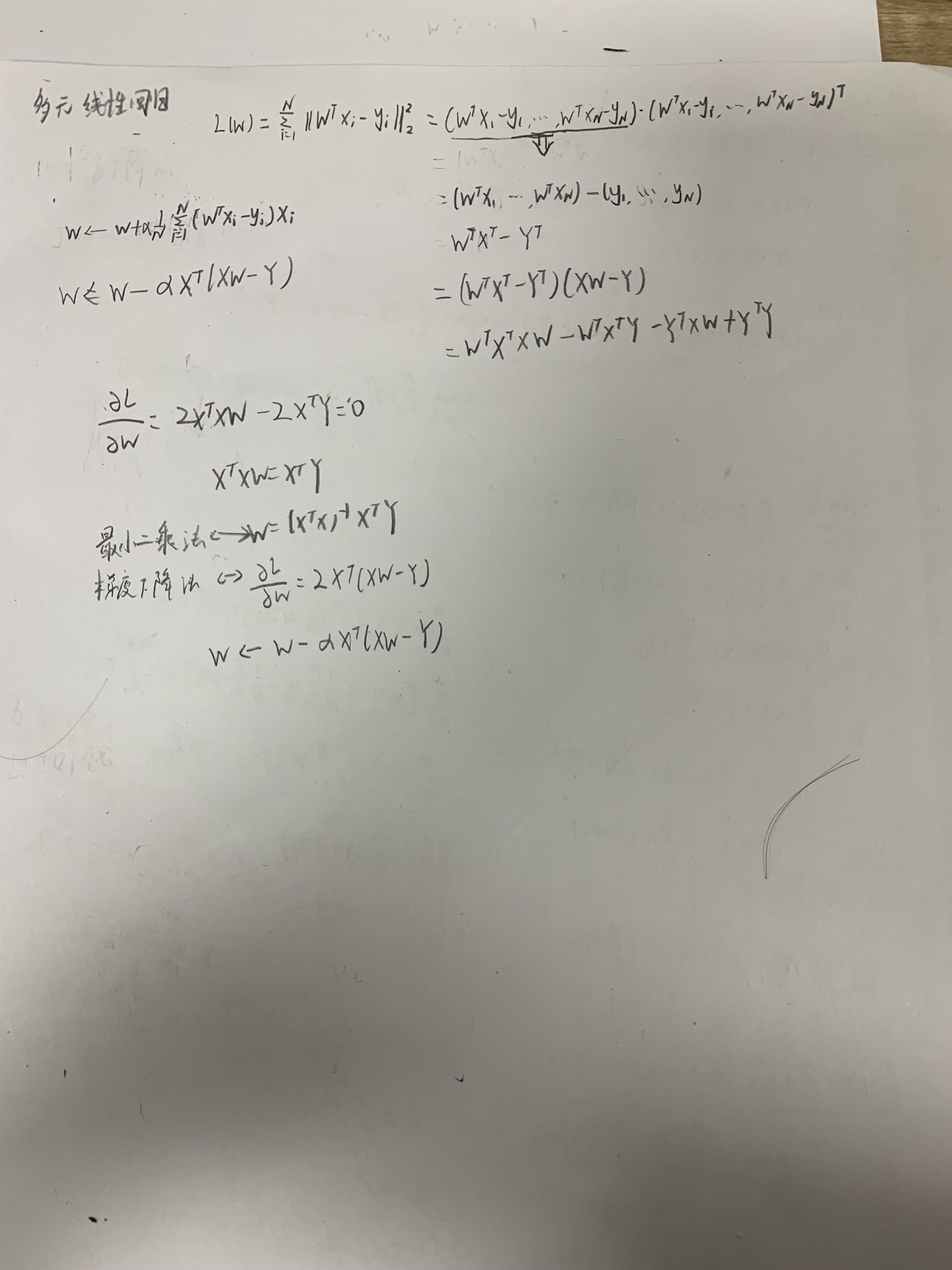

线性回归是最简单的模型,当噪声为高斯分布时,最大似然估计的解等于最小二乘法的解,当线性回归的损失函数加上L2正则化时,其最小二乘法的解等于权重为高斯分布下的最大后验概率估计的解,加上L1(lasso)正则化后,其等于拉普拉斯噪声先验下的解。

对于最小二乘估计,最合理的参数估计量应该使得模型能最好地拟合样本数据,也就是估计值和观测值之差的平方和最小

对于最大似然法,最合理的参数估计量应该使得从模型中抽取该n组样本观测值的概率最大,也就是概率分布函数或者说是似然函数最大。

显然,这是从不同原理出发的两种参数估计方法。因此最大似然法需要已知这个概率分布函数,一般假设其满足正态分布函数的特性,在这种情况下,最大似然估计和最小二乘估计是等价的,也就是说估计结果是相同的,但是原理和出发点完全不同。